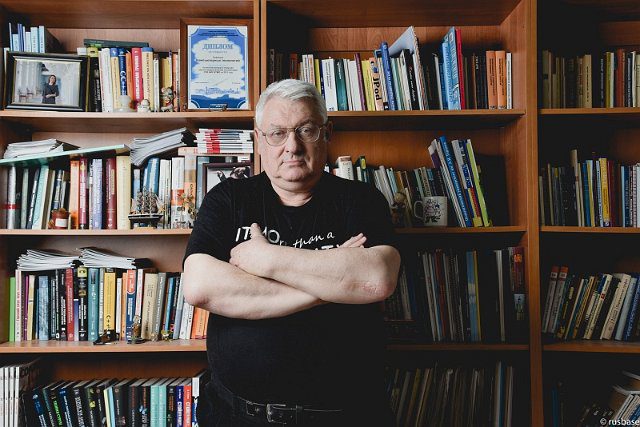

Об авторе: Анатолий Шалыто, профессор, д.т.н., Университет ИТМО.

9 октября 2024 года стало триумфальным для программистов новой формации: два представителя компании Google DeepMind – Демис Хассабис (Demis Hassabis, 48 лет, руководитель компании) и Джон Джампер (John Jumper, 39 лет) получили Нобелевскую (!) премию по химии «за предсказание структур белков». Дать предсказание трёхмерной структуры белка, основываясь исключительно на его аминокислотной последовательности, было важной исследовательской проблемой на протяжении более 50 лет. Предложенная под их руководством модель на основе глубокого обучения позволяет предсказывать структуры белков с атомарной точностью.

С точки зрения химии белки – одни из самых сложных молекулярных структур, которые можно себе представить. В 1959 году Джон Кендрю и Макс Перуц с помощью рентгеновской кристаллографии построили первые трёхмерные модели белков. В 1961 году Кристиан Анфинсен выяснил, что структура белка определяется последовательностью аминокислот в нем. В 1972 году он своей нобелевской речи рассказал о возможности перехода от генетической аминокислотной одномерной последовательности белка к её трёхмерной структуре, но как это сделать, он не знал. Говорят, что Анфинсен как бы сформулировал теорему Ферма в биологии. Знание трёхмерной структуры необходимо, так как к ней присоединяются другие компоненты живого. Отмечу, что при взаимодействии белки могут менять форму.

С тех пор учёных интересовал вопрос, как предсказать трёхмерную структуру белка, если указанная последовательность известна. Это было названо «сворачиванием белков». Неправильное сворачивание белков приводит к болезням. Белки называют «рабочими лошадками биологии». В 1994 году был запущен проект «Критическая оценка прогнозирования структуры белка» (CASP), который проходит каждые два года тестирует методы предсказания трёхмерной структуры белка.

К началу работ нынешних нобелевских лауреатов в этом направлении было установлено, что только 22 из 500 известных аминокислот используются в белках. На начало исследований лауреатов была известна структура только 150 белков, которые были определены за 40 лет экспериментальной биологии. Находить их структуру было дорого и сложно – так, в частности, необходимо было использовать, электронные микроскопы. Для исследования одного белка нужен был один аспирант, результатом многолетнего труда которого являлось определение структуры этого белка, в то время как с помощью компьютерной программы, разработанной под руководством лауреатов, это можно сделать за секунды. Указанный набор из 150 белков был тренировочным для разработанной нейронной сети. Потом он был резко расширен за счёт синтетически сгенерированных белков.

При создании программы команде из DeepMind пришлось разработать более 30 компонентных алгоритмов, чтобы «взломать» процесс сворачивания белков. При этом к самым большим инновациям относилось определение жёстко кодированных ограничений, связанных с физикой и эволюционной биологией. Это было необходимо знать, чтобы ограничить, например, такие параметры, как углы связей в белке, не влияя при этом на систему обучения. После этого сама системы стала изучать физику на тех примерах, которые ей были доступны.

К началу работ по этой тематике у команды, как будет показано ниже, был большой задел по использованию искусственного интеллекта (ИИ) в играх, что сильно помогло, так как конечная цель их исследований состояла не в том, чтобы взламывать игры, а в том, чтобы создавать и использовать полученные результаты для систем с ИИ общего назначения.

В 2018 году во время очередного соревнования, проводимого в рамках CASP, команда Хассабиса разработала модель на основе искусственного интеллекта AlphaFold (Fold – сгиб), которая предсказывала структуру белка с вероятностью 60% и превосходила все аналоги. Позже к группе исследователей присоединился Джампер, принявший участие в создании модели AlphaFold2. Вторая версия модели вышла в 2020 году и показала такие же результаты, как и с применением рентгеновской кристаллографии, хотя последний метод требует намного больше времени. С помощью AlphaFold2 команда под руководством Хассабиса и Джампера смогла предсказать структуру практически всех 200 миллионов белков, известных науке.

Обычно Нобелевские премии присуждают за научные открытия с солидной задержкой, но в данном случае прошло всего несколько лет. Говорят, что в этом случае Нобелевский комитет выступил как венчурный капиталист. Это связано с тем, что сразу всем стало ясно, что модель на основе нейронной сети для предсказания сложных структур белков под названием AlphaFold2 – очень полезный инструмент, который появился в 2020 году, и с тех пор его использовали два миллиона человек из 190 стран. В открытом доступе находится код модели и база данных с различными видами белков. Эта модель, по мнению многих, является стандартом в исследованиях по определению белковых структур. С её помощью были разработаны вакцины от малярии, различные лекарства, ферменты и многое другое.

15 июля 2021 года статья об этой модели была опубликована в Nature (Highly accurate protein structure prediction with AlphaFold). В ней Джампер – первый автор (человек, выполнивший наибольшую часть научной работы), а Хассабис – последний (человек, который внёс наибольший вклад в появление научной работы).

22 июля 2021 года (через неделю после предыдущей публикации) у Джампера и Хассабиса, как у соруководителей, вышла по этой тематике ещё одна статья в Nature (Highly accurate protein structure prediction for the human proteome).

До этого в 2020 году они также опубликовали статью в Nature по этой тематике (Improved protein structure prediction using potentials from deep learning). В ней Джампер третий автор, а Хассабис – снова последний.

В 2022 году лауреаты опубликовали в другом, но близком к Nature журнале (Nature methods) статью: Protein structure predictions to atomic accuracy with AlphaFold.

В 2023 году в Science была опубликована статья (Accurate proteome-wide missense variant effect prediction with AlphaMissense), среди авторов которой Джампер, Хассабис и Пушмит Колли (Pushmeet Kohli) – научный руководитель компании Google DeepMind. Вот о чём статья: «Изменения одной аминокислоты в белках иногда оказывают незначительное влияние, но часто могут привести к проблемам в сворачивании, активности или стабильности белка. Лишь небольшая часть вариантов была экспериментально исследована, но существует огромное число данных о биологических последовательностях, которые можно использовать в качестве обучающих данных для машинного обучения. Авторами была разработана модель глубокого обучения AlphaMissense, основанная на модели AlphaFold2, которая обучается на данных о частоте популяций и использует последовательность и прогнозируемый структурный контекст, что способствуют повышению производительности модели. Авторы сравнили метод, на котором базируется эта модель, с аналогичными методами, используя клинические базы данных, не включенные в обучение. Прогнозы для всех одноаминокислотных замен в протеоме человека предоставляются в качестве ресурса сообщества.

Хассабиса публикациями в Nature и связанных с ним журналах не удивить: еще в 2015 году у него была статья в Nature (Human-level control through deep reinforcement learning). Демис на 14 октября 2024 имеет индекс Хирша (в Google Scholar) – 92.

Да и чем его вообще можно удивить (разве что присуждением им Нобелевской премии), если в марте 2024 года Хассабис был удостоен титула сэр и рыцарского звания за «заслуги перед искусственным интеллектом»! Он член Королевской инженерной академии Великобритании (2017) и Лондонского Королевского общества (2018). Родился и вырос в Северном Лондоне в семье грека-киприота и матери-китаянки из Сингапура.

В 2024 года Хассабис и Джампер вместе с коллективом авторов (в том числе из компании Isomorphic Labs, которая также принадлежит Alphabet), разработали модель AlphaFold3 на основе модели AlphaFold2, однако каждый её компонент претерпел существенные модификации. Ядром новой модели является улучшенная версия модуля глубокого обучения Evoformer, использованного в AlphaFold2. После обработки входных данных AlphaFold3 предсказывает структуру белка с помощью диффузионной модели, схожей с моделями, которые используются для генерирования изображений. Процесс начинается с неорганизованного облака атомов, которое через множество итераций превращается в максимально точную белковую структуру. Тем временем Isomorphic Labs уже сотрудничает с разными фармпроизводителями, чтобы использовать модель для дизайна новых лекарств. Эта модель менее открыта по сравнению с AlphaFold2. Статью о новой модели быстро опубликовали в Nature (Accurate structure prediction of biomolecular interactions with AlphaFold 3).

Работы в области биологии в DeepMind продолжаются, и Хассабис собирается в конце концов провести с помощью вычислительных методов виртуальную имитацию клетки. Он обсуждает это с лауреатом Нобелевской премии по физиологии или медицине 2001 года Полом Нерсом (Paul Nurce) – директором института Фрэнсиса Крика, который находится в Лондоне через дорогу от DeepMind. Известно, что математика является идеальным языком описания физики, и Хассибис думает, что ИИ, возможно, может стать таким языком для описания биологии, которая слишком запутанна и сложна, чтобы разобраться в её правилах.

Джеффри Хинтон (он праправнук Буля), которому за день до обсуждаемых лауреатов тоже была присуждена Нобелевская премия, но по физике с формулировкой «за фундаментальные открытия и изобретения, обеспечивающие машинное обучение с помощью искусственных нейронных сетей», тоже работал в Google (с 2013 по 2023 год) – был одним из вице-президентов.

Хинтон работал над нейросетями ещё с конца шестидесятых, когда учился в Кембридже. Если он в то время заводил речь о машинном обучении, остальные смотрели на него так, будто он приводит аргументы в пользу геоцентрической системы мира или лечения пиявками. Однако Хинтон уже тогда понимал, что нейросеть сможет справиться со сложными задачами, если будет состоять из многих слоёв. «Людям очень понравилась идея многослойных нейронных сетей, но мы её переоценили», – вспоминает Хинтон. Учёные быстро вернулись к своему прежнему мнению: Хинтона и людей вроде него снова стали считать чудаками и визионерами. Через много лет то же и по той же причине в академической среде выслушивал и Хассибис.

Что было сделано в DeepMind до биологии?

Создатель Ethereum Виталик Бутерин в качестве одного советов, как добиться успеха, рекомендовал играть только в те игры, которые Вы написали сами. Однако этот совет не универсален, так как идеология компании DeepMind с самого начала базировалась на играх в игры, которые она написала не сама, но в них должны были играть не сотрудники компании, а созданные ими разновидности ИИ.

По мнению Хассабиса, игры являются удобной тестовой площадкой (полигоном) для разработки ИИ. В играх обычно ведётся подсчёт очков, с помощью которых легко измерять прогресс, если он есть. Ещё одно объяснение, почему для исследований он выбрал игры, а не более традиционную для ИИ робототехнику, состоит в том, что «роботы – дорогие, медленные и часто ломаются, и исследователю приходится отвлекаться на починку их механических деталей».

В игру Go, например, играют тысячи лет, и многие условия, выполнение которых ведёт к победе, известны. В этой игре легко понять, за что надо давать вознаграждение. Партии удобно запускать миллионами в облаке.

Указанная выше ссылка на YouTube – это более чем двухчасовое интервью Хассабиса, которое взял у него Лекс Фридман (Lex Fridman), общее число просмотров видеоблога которого на YouTube составляет почти полмиллиарда.

Естественно, что идея с использованием игр при проведении работ по ИИ не нова: ещё в начале 60-х годов прошлого века основоположники ИИ в СССР начинали свои исследования с таких игр, как «подкидной дурак» и шахматы, одного слабые вычислительные средства (о больших данных тогда никто и не думал) ограничивали применяемые подходы, что не позволило достичь, например, в шахматах, уровня сегодняшнего дня.

Хассабис тренировал свой мозг на играх, начиная с шахмат в раннем возрасте. Он начал играть в шахматы в четыре года. Выигрыш в шахматном соревновании позволил купить ему первый шахматный компьютер. В восемь лет Демис начал программировать, так как купил компьютер тоже на деньги за победы в шахматах. Потом купил книги по программированию. Начал разрабатывать собственные игры. В 13 лет имел очень высокий по тем временам коэффициент Эло (2300) и стал гроссмейстером. Он играл за сборную Англии и до 14 лет собирался стать профессиональным шахматистом.

Но всё время помнил, что написанием шахматных программ занимались великие учёные – Тьюринг и Шеннон, и решил отказаться от карьеры шахматиста, но не от игр в широком смысле этого слова. При этом отмечу, что у Тьюринга не было возможности исполнить написанную им программу иначе как вручную. Шеннон написал свою программу в 1949 году. Он считал, что шахматы – это дрозофила для ИИ (дрозофила – самое подходящее для изучения мутаций животное, генетики многи дрозофиле обязаны – ред.). Хассабис с ним согласен. Шахматы использовались в исследованиях с самого начала развития ИИ.

Демис использовал ИИ в 12 лет, когда программировал игру несколько более простую, чем шахматы. Потом начал писать игры профессионально. В них тоже применял ИИ. Его карьера началась в компании Bullfrog Productions, где он разрабатывал игру Syndicate. В 1994 году в 17 лет он стал соавтором и ведущим программистом игры Theme Park, работая с дизайнером этой игры Питером Молинье. Игра разошлась по миру миллионами экземпляров.

Хассабис рано понял, что всё в мире сводится к умножению матриц, а это делают графические процессоры. В дальнейшем использовал их при разработке игр. Впервые использовал обучение с подкреплением в игре «Черное и белое».

Он окончил школу в 16 лет на два года раньше сверстников. Был принят в Кембриджский университет, но ему разрешили заниматься там только с 18 лет. Закончил этот университет по информатике с отличием. После этого защитил PhD-диссертацию в области когнитивной нейробиологии в Университетском колледже Лондона в 2009 году. Это укрепило его веру в то, что на универсальной машине Тьюринга, в конце концов, можно будет моделировать мозг, не привлекая ничего квантового, как предполагал другой Нобелевский лауреат – Роджер Пенроуз. В аспирантуре проводил исследования по нейробиологии и ИИ.

После защиты диссертации Хассабис был постдоком в MIT, в котором в то время ещё работали некоторые основоположники ИИ, например, Марвин Минский, который умер в 2016 г. Они, в частности, сочли, что ИИ не работает, после того как потрачтили много сил в 90-е годы на исследования в этой области. Хассабиса иначе как сумасшедшим они не считали, так как он спорил с ними, доказывая, что, используя процедуру обучения, в этой области можно добиться принципиально новых результатов.

Кстати, куда идти дальше в ИИ не знали не только американские отцы-основатели этой области, но и наши. Так, например, в 2002 году было опубликовано интервью об ИИ с Адельсоном-Вельским – выдающимся ученым вообще, а в этой области в частности, из которого сегодня становится ясно, что он, как и все остальные в то время, не знал, что «делать» с шахматами дальше – игры, для которой с его участием была разработана программа «Каисса», ставшая в 1974 году чемпионом мира среди компьютерных программ.

Примерно в это время Хинтон изобрел глубокое обучение, но в промышленности об этом никто не знал. Он же уже тогда понимал, что нейросеть сможет справиться со сложными задачами, если будет состоять из многих слоёв.

Кроме глубокого обучения Хассибису с коллегами нравилось обучение с подкреплением, и они решили расширить его область применения. Кстати, из неврологии известно, что мозг приматов развивается за счёт обучения с подкреплением.

В результате в 2010 году Хассибис рискнул и совместно с Шейном Леггом и Мустафой Сулейманом, который сейчас возглавляет разработку ИИ в Microsoft, создал компанию DeepMind, наняв в неё несколько инженеров, известных ему по разработке игр. Компания стала выполнять исследования по созданию многофункционального ИИ для игр, со временем привлекая к этим работам учёных из различных университетов, например, Кембриджского. В момент организации компании они не сказали об этом своим профессорам, так как знали их мнение по этому вопросу – молодёжь совершала карьерное самоубийство.

Почти с самого начала в компании была обеспечена междисциплинарность. Там работали программисты, специалисты по машинному обучению, инженеры. нейробиологи, биологи, физики, математики, философы, специалисты по этике. Это было связано с выбранной ими миссией – фундаментально понять интеллект и воссоздать его искусственно, а затем использовать это на пользу общества для решения многих других проблем. Междисциплинарность в некотором смысле обеспечивала возрождение духа Bell Labs.

В то время шахматные программы были специализированными – они были не способны играть даже в простейшие «Крестики и нолики», не говоря уже о более сложных играх. Людей же (для начала инвесторов) можно было заинтересовать только более универсальными программами с использованием ИИ.

Сначала считалось, что ИИ не может обыграть человека в шахматы, а тем более в Go, но это со временем им удалось, что расширило понимание применения ИИ в других областях.

В 2014 году компания была приобретена Google, и Хассабис стал миллионером. Это произошло после публикации статьи (Playing Atari with Deep Reinforcement Learning) об ИИ, успешно играющего в семь различных Atari-игр (Pong, Breakout, Space Invaders, Seaquest, Beamrider, Enduro и Q*bert).

ИИ DeepMind не был запрограммирован (в отличии от программ других авторов) под конкретную игру. В начале обучения система ничего не знала о правилах игры и училась играть самостоятельно, используя на входе только пиксельное изображение и информацию об очках, получаемых в ходе игры. Про это в 2015 году была опубликована статья в Nature (Human-level control through deep reinforcement learning), в которой Хассабис там снова последний автор. У статьи на 14 октября 2024 года 32 045 просмотров, что очень много.

В дальнейшем компания разрабатывала ИИ для более сложных игр, включая StarСraft II. Программа для игр в жанре стратегии в реальном времени называется AlphaStar. Про эту программу также была опубликована статья в Nature (Grandmaster level in StarCraft II using multi-agent reinforcement learning). Здесь Хассабис предпоследний автор.

Хассабис не жалеет о том, что продал компанию 10 лет назад, так как в то время в Великобритании не было возможности собрать сотни миллионов долларов, которые потребовались для того, чтобы конкурировать в глобальном масштабе.

В 2010 году в Великобритании никто не хотел вкладываться в нечто, что имело долгий срок окупаемости. В Америке венчурные капиталисты тоже не хотели в такое вкладывать, но были отдельные предприниматели (в их числе Илон Маск), которые поверили в ИИ. Хассабис называет их «чокнутыми». Демис остался в Англии, так как, во-первых, любит Лондон, а, во-вторых, в этой стране много талантов – три или четыре из 10 лучших университета мира находится здесь. В Англии по сей день чувствуется историческое влияние таких гигантов, как Чарльз Бэббидж и Алан Тьюринг.

В то время талантливых людей можно было получить почти без конкуренции, если они не хотели работать в банках и хедж-фондах. Лет через семь IT-гиганты организовали филиалы в Лондоне, а венчурные капиталисты обратили на эту тематику внимание, и конкуренция за таланты резко увеличилась. DeepMind сыграла в этом немаловажную роль.

В 2014 году DeepMind опубликовал архитектуру гибридной нейронной сети, состоящую из рекуррентной нейросети и внешней памяти. Нейросеть использует внешнюю память для записи и последующего чтения информации так же, как это делает машина Тьюринга, поэтому архитектуре дали название «Нейронная машина Тьюринга» (Neural Turing Machine). В экспериментах нейросеть успешно обучалась таким простым алгоритмам, как копирование, сортировка, ассоциативная память. В 2016 году об этом была опубликована статья в Nature (Hybrid computing using a neural network with dynamic external memory). Здесь Хассабис последний автор.

В 2015 году компания Google DeepMind разработала программу AlphaGo для игры в Go, которая считается святым Граалем искусственного интеллекта. Они знали, что, если они «взломают» эту игру, то сделают что-то очень большое. Пошаговый анализ игры помогал разработчикам понять как «думает» их создание. Программа обучалась на 100 000 партий. Сначала разработчики заставили программу имитировать игру человека. Потом она самостоятельно в процессе обучения с подкреплением много миллионов раз играла против разных версий самой сбя, учась на своих ошибках. В основе этой программы лежат глубокие нейронные сети, которые как бы имитируют сеть нейронов в человеческом мозге.

В январе 2016 году AlphaGo впервые выиграла у достаточно сильного игрока – Фань Хуэя, о чем более подробно будет рассказано ниже.

В марте этого же года AlphaGo на стандартной доске 19×19 сыграл матч из пяти партий в Go с одним из сильнейших игроков мира Ли Седолем из Южной Кореи. Его считали гением этой игры. В 2008 году он был признан лучшим игроком мира, а затем и величайшим игроком первого десятилетия 21-го века. Он победил на 18 крупных международных соревнованиях. Седаль был уверен, что он намного сильнее Фань Хуэя, а так как прошло всего два месяца, то, по его мнению, программа не могла быть сильно улучшена. Он надеялся на счет 5:0 или 4:1, тем более что приз на этих соревнованиях составлял один миллион долларов.

Программа выиграла со счетом 4:1. При этом AlphaGo продемонстрировала такую игру, которую ожидали от программ не ранее, чем через 10 лет.

В первой партии она долго думала над ответом на первый ход человека, что удивило многих. Все её действия не были не похожи на человеческие. Седоль начал нервничать, и через некоторое время ко всеобщему удивлению сдался. Люди хотели, чтобы человек победил программу, но надо помнить, что программу и данные для её обучения создали люди, и поэтому команда, состоящая из людей, таким замысловатым способом победила гения, что является высшим признаком человеческой изобретательности и ума. Эта победа признана прорывом в ИИ. Седоль тоже был очень удивлён проигрышем. Он сказал, что программа играла идеально, но он верил, что отыграется в следующих партиях. Реакция на это поражение в Корее была просто ошеломляющей. В Китае игру посмотрело около 60 миллионов человек, а в мире – 80 миллионов.

Во второй партии программа сделала 37 ход, который для человека был абсолютно нелогичен (вероятность того, чтобы он был сделан человеком – одна десятитысячная), и многие не понимали его смысл, но оказалось, что он был связан со стратегическим «мышлением» программы. Это открыло новое её качество – она «придумала» новое, творческой, необычное. Ход был очень удивителен и для Седоля. После этого хода игра как бы перевернулась, и Седоль задумался на 12 минут. Через некоторое время после этого программа выиграла. На пресс-конференции Седоль сказал: «Вчера я был удивлен, а сегодня потерял дар речи!» После этой партии один из китайских специалистов сказал: «Если AlphaGo победит, то, возможно, мы начнем понимать, о чём эта игра».

В третьей партии Седоль поменял свой стиль игры и проиграл. Гений проиграл три партии подряд, так как у него не получалось играть свою игру. Комментаторы посчитали, что здесь творится история. Седоль очень хотел победить и перепробовал всё… На пресс-конференции он извинился, что был таким бессильным.

Перед четвертой партий у Седоля появилась гипотеза уязвимости в программе, и он сделал ход, который поверг программу в шок. В результате Седоль выиграл. Он доказал, что слабые и хрупкие люди могут еще за себя постоять… У Седаля с начала матча произошла переоценка ценностей и, он посчитал, эту одну победу невероятным событием. Найденный им ход назвали ходом Бога. Это была первая и, к сожалению или счастью, последняя победа человека над этой программой, которая после поражения в этой партии была дообучена, и пятую партию Седоль проиграл. Двадцатилетняя мечта Хассибиса сбылась! За эту победу программа получила девятый профессиональный дан – высший в этой игре!

В 2016 году по этой тематике была опубликована статья в Nature (Mastering the game of Go with deep neural networks and tree search). Здесь Хассабис последний автор.

В статье рассказано, что AlphaGo состоит из трёх основных компонент: 1. Политическая сеть, которая обучена подражать игрокам. 2. Дерево поиска (вариантов), предназначенное для просмотра вариантов игры и выяснения того, что произойдет в будущем. 3. Сеть стоимости (ценностей), оценивающая позицию и определяющая вероятность выигрыша при нахождении в ней. Программа работает так: в некоторой позиции политическая сеть сканирует её и определяет перспективный план игры, потом строится дерево поиска и, наконец, используется сеть стоимости, которая сообщает, насколько многообещающим является результат в рассматриваемой позиции. В целом программа пытается максимизировать вероятность выигрыша.

В январе 2017 году AlphaGo сразилась с сильнейшими игроками по игре Go в серии онлайн-матчей. В одном из них участвовал сильнейший игрок в мире, чемпион Китая Кэ Цзе, которого AlphaGo переиграла, как и всех других мастеров. Очень важным является то, что AlphaGo, используя обучение с подкреплением, постоянно обучается играя сама с собой. В мае 2017 года она в очном поединке обыграла Кэ Цзе.

В том же году вышел большой документальный фильм под названием AlphaGo, который рассказывает о создании этой модели и её игре с Седолем. В фильме показано, как Хассибис приглашает Фань Хуэя (Fan Hui) – трёхкратного (с 2013 по 2015) чемпиона Европы по Go, проживавшего в Париже, сразиться с AlphaGo. Тот соглашается и в октябре 2015 года проигрывает матч из пяти партий со счётом 0:5, хотя до матча был уверен, что победит, так как считал, что против него будет играть всего-навсего программа.

После поражения Фань признал, что это был первый в истории случай, когда программа выиграла в Go у профессионала. Потом он рассказал о своём впечатлении об игре программы: «Она очень прочная и стабильная, как стена… Я знаю, что AlphaGo – компьютерная программа, но если бы мне никто об этом не сказал, то я бы подумал, что соперник играет немного странно, но, безусловно, очень сильно».

Не понимая прорыва, сделанного в AlphaGo, пресса писала, что Фань так давно живёт в Европе, что перестал быть профессионалом в Go. Для того, чтобы показать истинную силу программы её соперником должен был стать легендарный, исторический игрок, каким оказался гений века – Седоль, который имел девятый дан, а у Фаня был лишь второй. (Надо отметить, что достижения в Go в Китае, Южной Корее и Японии приравниваются к достижениям в музыке, поэзии и живописи.)

В этой ситуации создатели программы не только боялись проиграть, но и не хотели выглядеть глупо. Поэтому они перед матчем работали круглосуточно и вновь пригласили Фаня – на этот раз в качестве консультанта, и он очень помог им. Фань определял сильные и слабые стороны программы. В ней были обнаружены некоторые слабые стороны, которые не удалось устранить до матча. В матче участвовала 18-я версия программы. В Южной Корее восемь миллионов человек играют в Go, и поэтому матч, проходивший там, вызвал небывалый интерес. Матч был очень интересен и в мире. Что AlphaGo сделала с Седолем, который всеми силами старался защитить человеческий интеллект, а потом и с другими признанными профессионалами, описано выше.

В сентябре 2017 года в журнал Nature поступала статья, которая в октябре этого же года была там опубликована (Mastering the game of Go without human knowledge). Первым автором этой статьи был David Silver, а Хассабис был соруководителем совместно с Thore Graepel. В этой статье DeepMind сообщила о появлении ещё более сильной версии AlphaGo – AlphaGo Zero. Новая нейросеть сама обучалась играть в Gо с нуля, как говорится, «tabila rasa» (с чистого листа), соревнуясь сама с собой (обучение на партиях, сыгранных людьми, как это было в более ранних версиях AlphaGo, не использовалось). Всего за 21 день самообучения система достигла уровня силы игры AlphaGo Master, а затем и превзошла его. К 40-му дню она достигла ещё бо́льшего превосходства.

Матч из 100 партий в Go между AlphaGo Zero и AlphaGo со счётом 100:0 выиграла первая из них. Отсюда следует, что от накопленного за столетия человеческого опыта стало возможным отказаться, заменив его опытом машины, накопленным за несколько дней. Человеческий опыт оказался не только не полезен, но даже вреден.

Эксперты предполагали, что в шахматах преимущество ИИ будет меньше, чем в Go, так как игроки в эту игру из-за её сложности отставали от шахматистов в понимании игры на несколько сот лет. Это связано с тем, что пространство поиска решений в шахматах значительно меньше, чем в Go.

5 декабря 2017 года это предположение было опровергнуто, когда выпустили препринт про программу AlphaZero, которая была создана на базе AlphaGo Zero. Это была также самообучающаяся с нуля система, которая без изучения огромных баз данных, используя только правила игры, в процессе игры сама с собой за девять часов научилась обыгрывать лучшие из существовавших шахматных программ.

AlphaZero за это время сыграла сама с собой 44 миллиона партий. Сначала она играла чудовищно, но по прошествии небольшого времени обучилась так, что бросила вызов лучшей из имеющихся на тот момент шахматных программ Stockfish и сыграла с ней 100 партий. В 28 из них AlphaZero победила, не проиграв ни одной партии. Белыми из 50 партий 25 она выиграла, а 25 свела вничью. Это был триумф новой технологии, который и в этой игре перечёркивал все знания, накопленные человечеством за сотни лет! Прежние шахматные программы обучались за счёт их улучшений людьми, а AlphaZero обучалась сама и добилась на этом пути невиданных достижений!

В 2018 году статья про AlphaZero, которая к тому времени научилась играть не только в Go и шахматы, но и в сёги (японскую версию шахмат), была опубликована в Science (A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play).

В 2019 году из-за невозможности победить машину Седоль перестал участвовать в соревнованиях.

В 2020 году с участием Хассабиса в Nature была опубликована ещё одна статья (Mastering Atari, Go, chess and shogi by planning with a learned model), в которой изложен алгоритм MuZero, сочетающий древовидный поиск с изученной моделью, что позволило достичь сверхчеловеческой производительности в ряде визуально сложных областей без какого-либо знания их базовой динамики. Апробация выполнялась на 57 играх Atari3 и таких играх, как Go, шахматы, сёги.

Важность рассмотренных алгоритмов состоит в том, что поскольку они обучаются сами по себе, то могут выйти за рамки того, что программисты умеют делать, а это может позволить совершить прорывы в других областях.

Теперь об этих прорывах: о том, что DeepMind делала в последние годы, не обсуждая то, о чём уже сказано в самом начале текста.

В 2018 году компания обучила ИИ многозадачности в процессе интенсивной игровой сессии, используя игру Quake III Arena от компании ID Software и ALE (Arcade Learning Environment) с запущенными на ней 57 играми Atari. ALE – это простая среда, которая позволяет разрабатывать агентов ИИ для игр Atari.

В результате была разработана новая обучающая система, которую назвали IMPALA (Importance Weighted Actor-Learner Architectures). В ней ИИ передаёт тренировочные данные от группы «актёров» к группе «учеников» в процессе довольно быстрого прохождения игры. Через некоторое время, потраченное на тренировки, по уровню игры эта система сначала догнала, а затем и перегнала людей, являющихся сильными игроками.

C этими же вопросами связана публикация 2019 года с участием Хассабиса в Science (Human-level performance in 3D multiplayer games with population-based reinforcement learning).

В 2018 году DeepMind предложила метод обучения нейронных сетей с использованием видеоигр для консоли Atari. ИИ анализирует записи игр на YouTube, запоминает правильные тактики и эффективные ходы, сделанные людьми, и применяет их на практике.

В том же году в Nature с участием Хассабиса была опубликована статья, посвящённая навигации, обеспечиваемой на основе глубокого обучения с подкреплением (Vector-based navigation using grid-like representations in artificial agents).

В том же году в Science c участием Хассабиса была опубликована статья о разработанной в DeepMind системе искусственного зрения, получившей название Generative Query Network (GQN) — она не нуждается в размеченных данных. Вместо этого GQN сначала использует изображения, сделанные с разных точек, и создает абстрактное описание сцены, изучая её суть. Затем на основе этого представления сеть предсказывает, как будет выглядеть сцена с новой точки зрения (Neural scene representation and rendering).

Эта сеть может быть использована также и для создания изображений в 3D с использованием обычных плоских изображений. ИИ может генерировать на основе одной картинки невидимые стороны объектов. Ещё одна нейросеть – BigGAN – может генерировать пейзажи, изображения животных и предметов, похожие на фотографии.

В 2018 году сотрудники подразделения DeepMind Health опубликовали в Nature статью с участием Хассабиса (Clinically applicable deep learning for diagnosis and referral in retinal disease), посвящённую клиническому применению глубокого обучения при заболеваниях сетчатки.

В 2019 году сотрудники этого подразделения опубликовали в Nature статью с участием Хассабиса (A clinically applicable approach to continuous prediction of future acute kidney injury) о клиническом применении машинного обучения при заболеваниях почек.

В 2020 году сотрудники DeepMind Health опубликовали в Nature статью с участием Хассабиса о использовании ИИ при скрининге рака молочной железы (International evaluation of an AI system for breast cancer screening).

В 2022 году в Science с участием Хассабиса была опубликована статья о применении ИИ для сложной настольной игры Stratego (Mastering the game of Stratego with model-free multiagent reinforcement learning). Разработанная программа была названа DeepNash.

В этом же году DeepMind с участием Хассабиса опубликовала статью в Nature из области термоядерного синтеза – о магнитном контроле плазмы токамака посредством глубокого обучения с подкреплением (Magnetic control of tokamak plasmas through deep reinforcement learning).

В 2023 году DeepMind разработал модель GNoME (Graph Networks for Materials Exploration), которая позволила открыть 2,2 миллиона новых кристаллов, в том числе 421 тысячу стабильных материалов, которые могут стать основой технологий будущего. GNoME открыл 52 тысячи слоистых соединений, подобных графену. Ранее было идентифицировано около 1 000 таких материалов. ИИ также обнаружил 528 потенциальных литий-ионных проводников, что в 25 раз больше, чем было известно к тому времени. Обо всем этом рассказал Пушмит Колли. А вот статья об этом.

В 2023 году в DeepMind на основе машинного обучения была также разработана программа прогнозирования погоды GraphCast. Она способна менее чем за минуту прогнозировать характеристики погоды в течение 10 дней. Это существенно превосходит традиционные технологии прогнозирования. На практике ИИ предсказал выход урагана Ли на Лонг-Айленд за 10 дней до того, как это произошло.

В апреле 2023 году DeepMind объединилась с подразделением Google Brain и образовала компанию Google DeepMind для координации работ по ИИ в компании Google.

В 2024 году Google DeepMind представила агента SIMA. Это аббревиатура от четырёх слов: Scalable, Instructable, Multiworld Agent (масштабируемый, обучаемый, мультимировой агент) Он может понимать происходящее на экране и распознавать естественный язык. Агент учится играть в видеоигры, как человек. При этом он способен неплохо ориентироваться в самых разных играх. Авторы считают, что «научиться играть хотя бы в одну видеоигру – технологический подвиг, но, если обучить агента следовать инструкциям в разных игровых средах, то можно создать систему, которая окажется полезной для человека в реальном мире». Использовались девять игр, таких как No Man’s Sky, Teardown, Valheim, Goat Simulator 3. Рассматриваемый агент принимает данные с экрана, а управляет своими действиями с помощью клавиатуры и мыши. Он обучен выполнять порядка 600 базовых игровых приёмов, таких, как, например, повороты и подъём по лестнице. Предполагается, что со временем агент сможет научиться играть в любую видеоигру с открытым миром. SIMA обучен не побеждать, а запускать игру и делать то, что ему говорят. В дальнейшем планируется поручать агенту и более сложные функции.

В 2021 году ИИ начал получать новые научные результаты – становится инструментом для получения новых знаний. В этом году была опубликована статья в Nature с соруководителями Хассабисом и Колли, в которой приведены новые результаты, полученные AI в топологии и теории представлений (Advancing mathematics by guiding human intuition with AI).

В 2022 году DeepMind разработал нейросетевой алгоритм AlphaTensor, который позволил с помощью обучения с подкреплением найти несколько новых алгоритмов умножения матриц небольшой размерности. Статья про это была опубликована в том же году в Nature с соруководителями Хассабисом и Колли (Discovering faster matrix multiplication algorithms with reinforcement learning).

В 2023 году в Nature при участии Хассабиса была опубликована статья, в которой на основе машинного обучения был предложен агент Alph Dev, реализующий ряд новых быстрых алгоритмов, в том числе сортировку (Faster sorting algorithms discovered using deep reinforcement learning).

В 2024 году команда, состоящая в основном из сотрудников DeepMind, представила модель с открытым исходным кодом AlphaGeometry, способную решать задачи по геометрии на уровне медалиста Международной математической олимпиады.

Решать такие задачи очень сложно. Поэтому они представляются в специально разработанном языке, на котором ИИ может рассуждать о проблеме. Модель обучалась на огромном числе синтетических данных – специально сгенерированных задачах. Без публикации в Nature эти программисты теперь обойтись не могут: Solving olympiad geometry without human demonstrations. Среди авторов этой работы лауреатов Нобелевской премии нет. Говорят, что эта модель находит решения с помощью «грубой силы», недоступной человеку, но надо учесть, что всё это только начало, и, я предполагаю, со временем «грубость» в обращении с задачами будет уменьшена.

В 2024 году команда, состоящая в основном из сотрудников Google DeepMind, создала на базе большой лингвистической модели систему FunSearch (Searching in the Function Space – поиск в функциональном пространстве) для написания решений задач в виде компьютерных программ. Считается, что и с её помощью получены новые научные результаты. Так при решении «проблемы множества крышек» система создала программу, которая генерирует новые решения, которые не были известны математикам. То же самое произошло и при решении «задачи об упаковке контейнеров». И снова программисты опубликовались в Nature (Mathematical discoveries from program search with large language models). Нобелевских лауреатов среди авторов нет, но есть Колли.

Вместо того, чтобы генерировать решение, FunSearch «пишет» программу, которая находит решение. Решение конкретной задачи часто не даёт никакого представления о том, как решать другие смежные задачи, в то время как программа, которая находит решение, – это то, что человек может прочитать, интерпретировать и, возможно, использовать для генерирования идей для следующих задач. Основным ограничивающим фактором применения системы является то, что задачи должны иметь решения, проверяемые автоматически, что исключает многие задачи биологии, где гипотезы обычно приходится проверять с помощью лабораторных экспериментов.

Одна из последних разработок компании – это программа AlphaCode, которая, якобы, может писать код с такой же скоростью, что и среднестатистический программист .

Компания также проводит исследования в области ИИ «общего назначения». В 2022 г. она создала программу Gato. Это глубокая нейронная сеть для решения ряда сложных задач, обладающая мультимодальностью. Она может участвовать в диалоге, играть в видеоигры, управлять манипулятором робота и многое другое. Программа обучается решению нескольких задач одновременно – может переключаться между ними, не забывая один навык перед изучением другого. Эту технологию считают шагом к искусственному интеллекту общего назначения.

У Хассабиса, кроме перечисленных, также есть и другие статьи в Science и Nature, такие, как, например: When Fear Is Near: Threat Imminence Elicits Prefrontal-Periaqueductal Gray Shifts in Humans; A distributional code for value in dopamine-based reinforcement learning; Pushing the frontiers of density functionals by solving the fractional electron problem.

Исследования перечисленных проблем в DeepMind обычно не скоропалительны – они занимают не месяцы, а годы. Многие считают, что DeepMind являлась и является по сей день чем-то вроде программы Apollo в создании ИИ.

В заключение отмечу, что наряду с DeepMind исследования в области ИИ проводят и другие компании. Приведу два примера с играми.

В 2016 году компания OpenAI, которая была создана по инициативе Илона Маска для того, чтобы у DeepMind появился конкурент, также выпустила платформу для исследования машинного обучения с подкреплением. Проект создания бота для игры в Dota 2 был одним из шагов на пути к созданию ИИ, способного достигать целей в сложных, запутанных ситуациях с участием людей. В данном случае нейронная сеть несколько недель самообучалась, играя один на один сама с собой. Разработчики решили подойти к решению проблемы с чистого листа. Они поняли, что, если попытаться описать правила в открытой игре с тысячами переменных, то на это уйдет несколько месяцев. Вместо этого они настроили бота, ввели его в игру и дали полную свободу действий. Интересно, что, как отмечает Маск, эта компания из Open со временем превратилась в Closed (результаты её исследований закрыты – ред.).

В 2017 году нейронные сети обыграли человека в покер. Это казалось невозможным, так как в этой игре участники блефуют, что считалось неподвластным искусственному «разуму». В 2015 году учёные из университета в Альберте опубликовали статью по этой тематике в журнале Science (Heads-up limit hold’em poker is solved), а в 2019 году сотрудники университета Карнеги-Меллон создали ещё одну программу для игры в покер, про которую говорят, что она играет на сверхчеловеческом уровне.

Из изложенного следует, что если до последнего времени открытость программного обеспечения обеспечивалась публикацией на GitHub, то для программистов новой формации особенно важным становится публикация полученных результатов в ведущих научных журналах мира (что в отдельных случаях не исключает и публикацию и на GitHub). При этом отмечу, что в настоящее время ведущие IT-компании имеют более мощную публикационную активность в рассматриваемой области по сравнению с университетами, что является абсолютно новой тенденцией.

По двум публикациям своих учеников (Esaulova E. и Sergushichev A.) в Science и Nature и я знаю, как трудно там пройти рецензирование, и сколько времени оно обычно занимает, но, как мы видим, это практически не относится к обсуждаемым в этом тексте авторам, у которые, видимо, все их работы являются новаторскими. При этом отмечу, что во Франции считается, что если у учёного вышла статья в одном из трёх журналов: Nature, Science, Cell, то он продуктивно работает четыре года… А с нашими лауреатами всё происходит в Google.

Уровень премий и званий, которые получают программисты новой формации, свидетельствует о том, что их работы уже сегодня преобразуют науку, а не только практику, что характерно для большинства программистов.

Этот текст является продолжением двух моих текстов: «Все в нейросетях начиналось с пороговой логики» и «Фрагменты статьи «Великое пробуждение искусственного интеллекта» и кое-что ещё».